Udacityの Deep Learning Nanodegree Foundation の Week1 が終わりました。

シラバスでは学習時間の目安は 3-4 hours per week と書いてありましたがかれこれ20時間近く費やしています。。ヽ(;´Д`)ノ

誤差の逆伝搬の詳しい仕組みとか今までスルーしてきたところなのでそれなりに理解に時間がかかるのは仕方ない…とは思いつつも Week2以降大丈夫だろうか? 不安。。

それはおいとき、自分自身の理解をより深めるために少しずつ学習メモを残していきたいと思います。

1回目は 行列です。

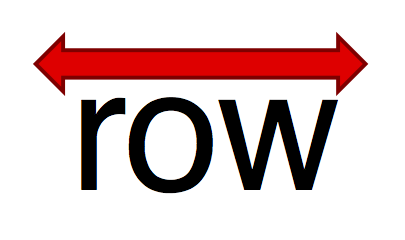

行と列とrowとcolumn

どちらが行でどちらが列か、、

イメージで覚えると忘れにくいです。次の図が分かりやすかったです。

http://sci.tea-nifty.com/blog/2014/12/row-column-f052.html

http://id.fnshr.info/2015/10/17/matrix/

http://lambdalisue.hatenablog.com/entry/2013/07/18/134507

行と列の関係は 画像処理に慣れている人は混乱するかもしれません。(私だけ??)

というのも、画像のサイズは通常、 W (横の大きさ) x H (縦の大きさ) と表現しますがこれを行列にすると逆になります。

つまり、W x H の画像は H x W の行列で表現されます。

numpyでの行ベクトルと列ベクトル

numpyの次の3つの構造のイメージつくでしょうか..?

(m, )

(m, 1)

(1, m)

正解・・・

(m, ) は 1次元ベクトル、

(m, 1) は 列ベクトル

(1, m) は 行ベクトル

(m, 1) はついつい横方向のベクトル、行ベクトルと思ってしまいますがこれは落とし穴で列ベクトルです。 慣れだとは思いますが。。

1次元ベクトルを列ベクトルに変換する方法

いったん2次元にしてから転置(transpose)する必要があります。 記述は 2パターンあります。

>>> data = np.array([1,2,3])

>>> data

array([1, 2, 3])

# 方法1

>>> data[:, None]

array([[1],

[2],

[3]])

# 方法1'

>>> data[:, np.newaxis]

array([[1],

[2],

[3]])

# 方法2

>>> np.array(data, ndmin=2).T

array([[1],

[2],

[3]])

2回目へ続く(はず。。)